Następna generacja: PlayStation kontra Xbox

Digital Foundry analizuje ostatnie doniesienia i porównuje konsole następnej generacji.

Kolejna wojna konsol jeszcze się nie zaczęła, ale bitewne szeregi już się formują i znamy specyfikację sprzętową, zarówno konsoli Microsoftu, jak i Sony. Durango kontra Orbis. Jedno jest pewne: rywalizacja w nadchodzącej generacji nie będzie przypominać niczego, co do tej pory widzieliśmy.

Durango to nazwa robocza następcy Xboksa 360, podczas gdy Orbis skrywa kolejne PlayStation.

Różnice pomiędzy konsolami są mniej wyraźne niż w jakiejkolwiek wcześniejszej generacji. Obie platformy są niemal identyczne pod kątem surowej architektury. Zasadniczo, Sony i Microsoft zmierzyły się z identycznymi problemami i szukały rozwiązania u tych samych ludzi. Efektem są dwa zbliżone do siebie, końcowe produkty. Jednak pewne różnice pomiędzy Durango i Orbisem występują i odzwierciedlają kierunek rozwoju całego rynku konsol, jaki przewidują obie firmy.

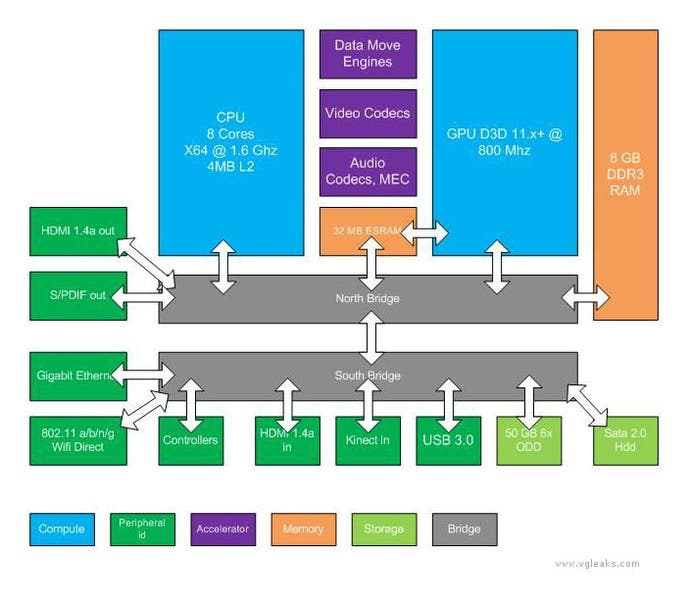

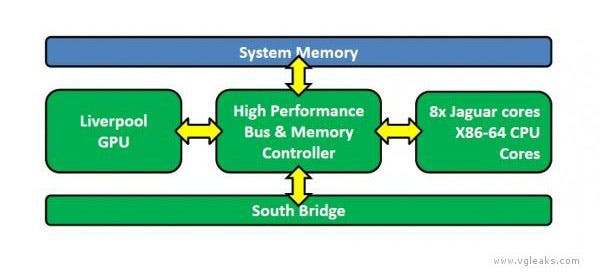

Nie zamierzamy się zbytnio rozwodzić na temat podobieństw, ale wspomnieliśmy już, że zarówno Xbox nowej generacji, jak i jego konkurent ze stajni Sony będą miały ten sam procesor, to jest 8-rdzeniowy układ firmy AMD o prędkości 1,6GHz, bazujący na nadchodzącej, energooszczędnej i wydajnej architekturze Jaguar. Z perspektywy grafiki, AMD również zastosowało tę samą technologię: rdzenie Graphics Core Next, które można znaleźć w popularnej serii kart Radeon HD 7xxx.

Tutaj właśnie następuje pierwsza rozbieżność: renderowanie grafiki polega na rozdzieleniu obciążenia pomiędzy kilka rdzeni i wiemy, że Xbox ma mieć 12 tzw. „jednostek obliczeniowych” (Compute Unit, CU), a PlayStation aż 18 - czyli o 50 proc. więcej. Liczby te często podważano przez kilka ostatnich tygodni, jednak nasze źródła na temat Orbisa potwierdzają specyfikację konsoli Sony. Z kolei wyciek od SuperDAE - potwierdzany przez naszych informatorów - świadczy o prawdziwości informacji na temat Durango. Doniesienia te mają około 9 miesięcy i pochodzą jeszcze z okresu testowego platformy - w teorii sprzęt można było jeszcze ulepszyć, jednak w praktyce to mało prawdopodobne. Nie można, ot tak, przerobić specyfikacji, bez kilkumiesięcznego poślizgu produkcji.

Czy zatem różnica w konstrukcji rdzenia graficznego to faktycznie znaczna przewaga PlayStation? Według udostępnionej przez VGleaks specyfikacji, cztery jednostki obliczeniowe (CU) są zarezerwowane na inne obliczenia, więc wspomniana 50-procentowa przewaga spada do 16 procent. Ponieważ do obliczeń, za które odpowiadają te jednostki, często należy na przykład fizyka - nic nie stoi na przeszkodzie, by wydzielić dla nich specyficzne elementy układu graficznego. Gra Just Cause 2, dla przykładu, używa rozwiązań Nvidii, tzw. CUDA, dla ulepszonych efektów wody, a popisowy trik Battlefielda 3 - deffered shading, na którym opiera się wspaniałe oświetlenie tej gry - został rozwiązany za pomocą tzw. Computer Shaders, zaimplementowanych w specyfikacji DirectX 11.

Durango, czyli następca Xboksa 360, opiera się na podobnym do PC podejściu, że to producenci gier decydują, jak wykorzystać zasoby GPU pomiędzy obliczenia i renderowanie. Dostrzegamy tu potencjalne, wąskie gardło, bo rendering i pozostałe obliczenia będą miały do dyspozycji tylko 12 jednostek GCN w konsoli Microsoftu, a nowe PlayStation ma dedykowane do tego elementy układu graficznego i opisaną powyżej przewagę pod względem liczby jednostek obliczeniowych.

Pozostałe informacje również wskazują na przewagę Sony, gdyż konsola ma posiadać zaskakującą liczbę 32 jednostek ROP w porównaniu do 16 w przypadku Durango. Jednostki ROP mają za zadanie przetworzenie informacji o pikselach i tekselach w ostateczny obraz. Dość prymitywnie to ujmując - im więcej ROP, tym wyższa możliwa rozdzielczość (sprzętowe wygładzanie krawędzi także wchodzi w zakres ROP). Szesnaście jednostek ROP to wystarczająca liczba, by wyświetlać obraz w rozdzielczości 1080p, a 32 to czysty nadmiar, który jednak może okazać się przydatny w wyświetlaniu obrazu 3D w FullHD czy nawet, dla przykładu, 4K (zobacz także: Digital Foundry kontra granie w 4K). Jednakże, według naszych źródeł, PlayStation jest projektowany głównie pod ekrany o maksymalnej rozdzielczości jedynie 1080p.

Sekretne „asy z rękawa”

Niektórzy twierdzą, że porównywanie Durango i Orbisa pod kątem powyższych danych nie ma sensu, a projektanci obu platform mają o wiele większą kontrolę nad architekturą niż wskazują na to suche dane i mogą adaptować konsole, wykorzystując rozmaite, sekretne „asy z rękawa”.

Porównanie mocy w teraflopach, czyli 1,23TF dla Durango i 1,84TF w przypadku Orbisa, według niektórych analityków nic nie znaczy i do pewnego stopnia to prawda. Patrząc jednak na specyfikację AMD dla sprzętu korzystającego z architektury GCN (Graphics Core Next), można zauważyć posługiwanie się podobną metodologią, bazującą na taktowaniu zegara i liczbie jednostek obliczeniowych. Nie jest to oczywiście alfa i omega mocy obliczeniowej, jednak te dokładne dane są używane przez samo AMD do szacowania suchej wydajności ich urządzeń. Można dostrzec, że układy konsol wpasowują się nieźle pomiędzy swe pecetowe odpowiedniki. W skrócie: liczba teraflopów nie przydaje się za bardzo do określenia czystej wydajności, ale do podstawowego porównania mocy jest całkiem przydatna.

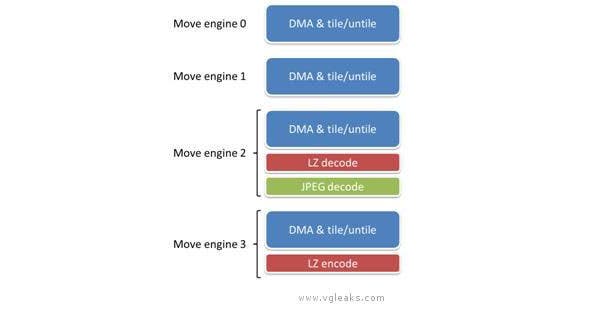

Nie sugerujemy tu oczywiście, że Durango i Orbis nie zostały indywidualnie dostosowane przez producentów. Oczywiście, że zostały. Widzimy jednak wspólną, w znacznym zakresie, architekturę obu systemów na podstawie tego, jak inżynierowie poradzili sobie z podobnymi problemami. Obie konsole mają sprzętowe kodery i dekodery wideo (więc można się spodziewać, że obie będą w stanie nagrywać i wysyłać do sieci gameplay z gry bez straty wydajności). Obie posiadają też własne procesory dźwięku i wsparcie dla dearchiwizacji danych w formacie LZ (coś zbliżonego do bezstratnej kompresji typu ZIP).

Jednak mamy też pewne intrygujące usprawnienia w specyfikacji nowego Xboksa. Akcelerator „Data Move Engines” zajmuje się kompresją i dekompresją sprzętową (oraz wsparciem dla JPEG - pewnie po to, by udźwignąć streaming z kamery Kinect). Mamy również wsparcie dla technologii texture swizzling. Niestety, problem stanowi fakt, że podstawowa funkcjonalność Move Engine jest tak zaprojektowana, by wycisnąć jak najwięcej z pamięci RAM, która jest znacznie bardziej złożona (i wolniejsza) niż w nadchodzącym PlayStation. Poza tym, większość dodatkowych modułów istnieje po to, by zmniejszyć obciążenie procesora, a nie, by zwiększyć wydajność układu graficznego. Jeśli zatem ktoś myślał, że sekretne „asy z rękawa” pomogą Xboksowi przebić dominację Orbisa, zawiedzie się.

W rzeczy samej, wiele funkcji przypisanych Move Engine - nakładanie i usuwanie tekstur, bezstratna dekompresja i dekompresja tekstur - często były przydzielone jednostkom SPU (Synergistic Processing Unit) obecnym w PlayStation 3. VGLeaks podaje specyfikacje przepustowości około 25GB/s, co jest dość wiarygodną liczbą, zbliżoną do wydajności SPU, które zajmowały się tymi samymi zadaniami. W istocie więc te dodatkowe elementy to coś w rodzaju dwóch lub trzech jednostek SPU, dostępnych w ramach 8-rdzeniowego procesora AMD. Orbis ma własne, indywidualne elementy, które realizują wiele podobnych funkcji i nadal ma komfort w postaci w pełni programowalnego modułu obliczeniowego, którego brak w Durango (nie licząc zasobów renderujących).

Fakt, że obecne w Durango, opisywane powyżej Data Move Engines w ogóle istnieją, pokazuje kolejną różnicę między obiema platformami nowej generacji: pamięć i to jak dane są rozprowadzane po systemie.

RAM: pojemność kontra przepustowość

Mając aż 8GB RAM względem „jedynie” 4GB u konkurenta, nowa konsola Microsoftu jest pamięciowym potworem. To dość ambitne posunięcie, spowodowane nadziejami Microsoftu, że ich nowy Xbox będzie czymś więcej niż tylko maszyną do grania. Sprzęt na pewno zarezerwuje większość RAM-u na swoje podstawowe funkcje, jednak z nieoficjalnych doniesień wynika, że konsola będzie w stanie odpalić dedykowane aplikacje i media podczas rozgrywki.

Jest jednak pewien problem. Wciśnięcie 8GB najszybszej pamięci w konsolę nie jest logistycznie możliwe. Główną przewagą Xboksa 360 nad PS3 było wspólne pole 512MB pamięci GDDR3. Jego najnowszy odpowiednik, GDDR5, używany jest głównie w pecetowych kartach graficznych. Problemem jednak jest fakt, że te moduły mogą być produkowane w określonych wielkościach. Największy możliwy i najtrudniejszy do wyprodukowania ma 512MB. Pierścień szesnastu takich kości na płycie głównej nie zadziała. Sony postawiło więc na bardziej zwarty system - mniej modułów pamięci, ale za to bardzo szybkich. Podobnie jak GDDR5, w PlayStation znajdzie się wspólna pamięć z całą swoją prędkością, jednak zostanie ograniczona do 4GB (są co prawda plotki o powiększeniu jej do 6/8GB, ale to mało prawdopodobne).

Sposobem Microsoftu na użycie 8GB RAM jest powrót do tańszych modułów DDR3 - obecnych w dzisiejszych pecetach i Wii U. Tu pojawia się kolejny problem, a konkretnie - przepustowość. Porównajmy te dane do wody przepływającej przez rurę - im szersza rura, tym szybciej woda przepływa. DDR3 ma jedynie jedną trzecią przepustowości GDDR5, bo „rura” jest znacznie cieńsza. Rozwiązanie Microsoftu? Wyposażenie Durango w 32MB szybkiej pamięci ESRAM, zaimplementowanej bezpośrednio w rdzeń graficzny, jednak dostępny również dla procesora. Ta mała pamięć cache jest w stanie działać jednocześnie z DDR3, a tak połączona przepustowość wzrasta z powrotem do około 170GB/s, to znów prawie tyle, co GDDR5 w Orbisie.

Co to oznacza w praktyce dla deweloperów? Cóż, jakkolwiek Microsoft by tego nie rozwiązał, to 32MB ESRAM zdaje się być jedynie doraźnym rozwiązaniem; nie tak szybkim i efektywnym, jak jedna wspólna pamięć Orbisa. Jednak mimo swoich wad, nie oznacza to, że takie rozwiązanie jest katastrofą dla Durango. Z perspektywy twórców gier, nie każdy element gry wymaga superszybkiej pamięci. Programy będą projektowane na DDR3, a jeśli przepustowość zacznie stanowić problem, to problematyczne elementy zostaną przeniesione na ESRAM. Tu przepustowości jest tyle, by zapewnić maksymalną wydajność tam, gdzie jest ona potrzebna.

Kolejnym faktem, który łagodzi różnice pomiędzy konsolami jest to, że Xbox ma operować na ulepszonej wersji DirectX 11 - wewnętrznie nazywaną DX 11.x. Bardzo więc możliwe, że pewne istotne funkcje renderowania będą już z automatu zoptymalizowane przez Microsoft do wykorzystywania ESRAM.

DirectX 11 kontra LibGCM

Wszystkie powyższe informacje zgrabnie prowadzą nas do rozważania na temat środowisk graficznych, jakie będą towarzyszyć nowym konsolom. Microsoft tradycyjnie rozszerzył obecne narzędzia używane do tworzenia tytułów na Xboksa 360. Zamiana PowerPC na 64-bitowy procesor x86 wprowadza całą gamę nowych rozszerzeń, zaprojektowanych do działania na nowym sprzęcie, kiedy zindywidualizowana wersja DX9, używana przez X360, ustępuje podobnie poprawionemu DX11.

Z tego, co słyszeliśmy, zmiana ma być niemal nieodczuwalna dla deweloperów, zwłaszcza tych, którzy pracowali już z DX11 przy projektach na PC. Choć część twórców martwi się, że zamknięcie się w API Microsoftu może stanowić problem, to faktem jest, że jedynie specyficzne funkcje DX11 są przypisane do architektury Durango. Również elastyczność, z jaką DirectX jest stosowany przypomina niemal legendarną już koncepcję programowania na naprawdę niskim poziomie. Na przykład, na Xboksie 360 Microsoft umożliwił twórcom załadowania danych shader do GPU w swojej rdzennej formie. Twórcy udostępniają dane sprzętowi, który je wczytuje - należy tylko upewnić się, że dane są na swoim miejscu i w odpowiednim formacie, zanim GPU je przetworzy. Mówiąc wprost, taka możliwość jest nadal obecna wewnątrz API DirectX, ale znacznie efektywniej twórcy piszą program bezpośrednio pod sprzęt.

W odniesieniu do zbliżającego się PlayStation, raczej mało prawdopodobne, że twórcy napotkają na problemy z narzędziami, z którymi zapoznali się już w przypadku PS3. Przejęcie w 2005 roku SN Systems miało na celu poprawienie środowiska do tworzenia gier pod konsole. Faktycznie, jakość środowiska znacznie się polepszyła. Do tego stopnia, że pewien doświadczony twórca, z którym rozmawialiśmy, ocenia narzędzia PlayStation Vita jako najlepsze, z jakich do tej pory korzystał.

W przypadku Orbisa, Sony zastosowało nowy wariant bibliotek LibGCM, który był wykorzystywany przy PS3 i Vita. Pozwala to twórcom na bezpośrednie adresowanie kodu do sprzętu, a elementy procesora graficznego AMD mogą być wykorzystywane w sposób, jaki będzie niedostępny przy DirectX. Wystarczy tylko spojrzeć na gry, takie jak God of War czy Uncharted, by zauważyć, jak Sony podchodzi do wykorzystania własnego sprzętu. To przecież do dziś najładniejsze gry , mimo że wykorzystują kartę graficzną wywodzącą się z przestarzałego sprzętu Nvidii z 2005 roku. Oczywiście, w przypadku PS3, GPU to tylko jeden element składający się na oferowaną moc, lecz fakty pozostają faktami - twórcy wyciskają z układu RSX wydajność, o której mogliby tylko pomarzyć w chwili projektowania konsoli.

Pole bitwy dla next-genów niemal gotowe

W 2005 roku Microsoft i Sony ujawniły projekty konsol następnej generacji - Xboksa 360 i PlayStation 3. Były to jednostki sprzętowe o ambitnej specyfikacji. Kosztem poboru mocy chciały osiągnąć nową jakość (ponosząc często katastrofalne konsekwencje w niezawodności) i zaadoptowały elementy wydajności PC do swych konstrukcji. Microsoft wypłynął na szerokie wody pod względem wydajności GPU - układ graficzny Xenos architekturalnie wybiegał w przyszłość i był bardziej zaawansowany niż cokolwiek w tamtych czasach. Sony zaś zaryzykowało z procesorem Cell i napędem Blu-Ray. W tym przypadku skomplikowana architektura CPU, z którą wielu twórców miewało problemy i system magazynowania danych, który niewielu w pełni wykorzystało - to elementy, które ponad wszystko inne spowodowały przepaść pomiędzy pierwszo-, i trzeciorzędnymi tytułami.

Niektórzy mogą stwierdzić, że w nadchodzącej generacji zobaczymy produkty oszczędne, w których podejście „mocy za wszelką cenę” wykorzystane wcześniej w Xboksie 360 i PlayStation 3 zastąpiło nieco rozsądniejsze podejście. To podejście polegające na wzięciu na warsztat obecnej architektury i wyciśnięcie z niej jak najwięcej w zamkniętym pudełku. Nie jest zatem zaskoczeniem, że tak Microsoft, jak i Sony w obliczu podobnych celów sięgnęły po podobne części od tego samego producenta, bazujące na istniejącej już technologii, a w przypadku CPU - na sprawdzonej, ulepszonej wersji obecnie dostępnych procesorów. Być może nachodzącym konsolom brakuje nieco tego przyszłościowego podejścia. Główne różnice są dużo mniejsze w nowych platformach - Sony zainwestowało bardzo w wydajność, kiedy Microsoft stawia na RAM.

Na papierze nowe PlayStation wygląda na znacznie bardziej zwartą, mocniejszą i bardziej zorientowana na gry konsolę. Z kolei Durango, z niewiarygodnym pomysłem Microsoftu na zaadaptowanie 8GB pamięci, potwierdza hipotezę o planach zrobienia z nowego Xboksa nie tyle dedykowanego sprzętu do grania, co całego centrum multimedialnego. Pytanie, do jakiego stopnia te plany wpłyną na moc obliczeniową dostępną dla twórców gier...