Nadchodzi rewolucja w tworzeniu gier. Sztuczna inteligencja tworzy niebywałe obrazy

Sprawdzamy DALL-E, Midjourney i Stable Diffusion.

Nadeszła era obrazów generowanych przez sztuczną inteligencję. Wystarczy wpisać krótką instrukcję, by kilka chwil później cieszyć się pięknymi ilustracjami, szkicami i zdjęciami. Korzystając z uczenia maszynowego, najnowsze karty graficzne tworzą imponujące i profesjonalne widoki, przy minimalnym udziale człowieka. Jak wpłynie to na gry wideo? Wiele współczesnych tytułów wymaga pracy wielu grafików, odpowiedzialnych za tekstury czy grafiki koncepcyjne. Jeśli deweloperzy wykorzystają możliwości nowej technologii, być może wzrośnie tempo pracy - bez utraty jakości.

Jak jednak z każdą przełomową innowacją, nie brakuje kontrowersji. Jaka jest rola grafika, jeśli maszyny generują wysokiej jakości obrazy tak szybko i łatwo? I co z danymi służącymi do „trenowania” algorytmów? Czy można przyznać, że uczenia maszynowe naśladuje po prostu istniejące dzieła ludzi? Nie brakuje zagadnień etycznych, na które trzeba będzie odpowiedzieć. Biorąc pod uwagę tempo rozwoju SI w tej dziedzinie - odpowiedzieć raczej prędko.

W tak zwanym międzyczasie skupiamy się na efektywności technologii dostępnych już teraz. Wypróbowaliśmy DALL-E 2, Stable Diffusion oraz Midjourney. Rezultaty znaleźć można w materiale wideo poniżej. Wygenerowaliśmy je samodzielnie, korzystając z sieciowych interfejsów lub lokalnie, na własnym sprzęcie.

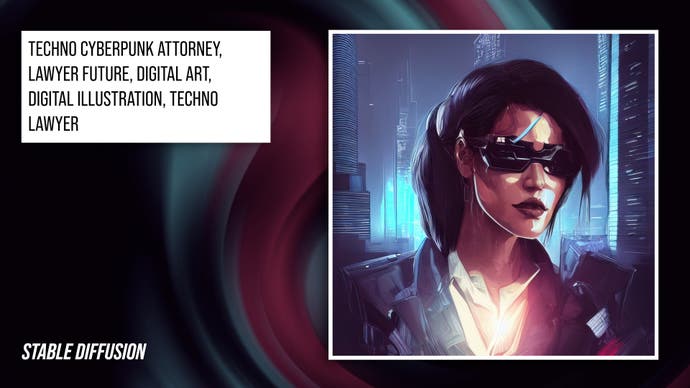

Domyślą metodą tworzenia obrazów w tych systemach jest obecnie „podpowiadanie”. Wpisujemy po prostu, co chcemy wygenerować, a SI bierze się za realizację zlecenia najlepiej, jak potrafi. W przypadku DALL-E 2 najlepiej sprawdza się proste połączenie krótkiego opisu i jakiejś stylizacji. Dodanie przymiotników na końcu często pomaga poprawić jakość.

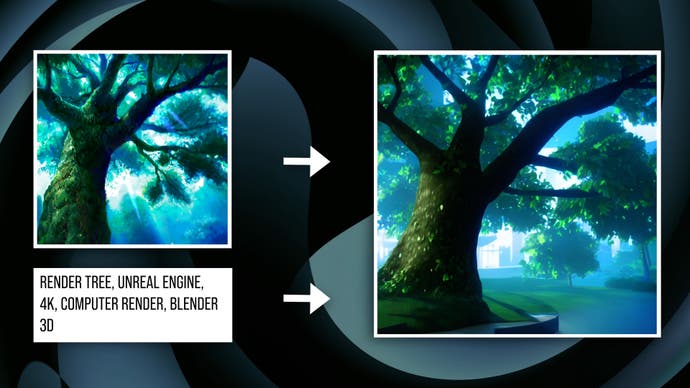

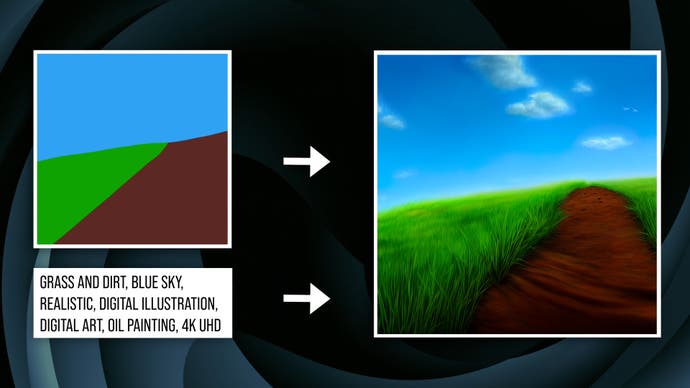

Jest też inna forma podpowiada, w ramach której oferujemy oprogramowaniu podstawowy obraz, a do tego słowne polecenie, kierunkujące wykonanie całkiem nowej ilustracji. Obecnie opcję tę w pełni wspiera tylko Stable Diffusion. Jak wiele innych technik SI, generowanie obrazów działa na bazie próbkowania istniejących danych - w tym przypadku, bazy danych obrazków - i tworzenie parametrów na ich oparciu. Siląc się na uproszczenie, podobnie funkcjonuje DLSS czy też generator tekstów GPT-3. Sztuczna Inteligencja „uczy się” jak tworzyć, ale z nadludzką prędkością i wszechstronnością.

Przynamniej teoretycznie takie rozwiązania powinny być ograniczane przez bazę danych - miliardy obrazów i przypisanych do nich słów kluczowych. W praktyce jednak zmiennych jest tak dużo, że narzędzia są bardzo elastyczne. W najlepszych przypadkach SI w pewnym sensie „nauczyło się” jak rozumiemy i szufladkujemy wizualne informacje. Jest też losowość, by nawet ta sama podpowiedź wpisana dwukrotnie wygenerowała nowe, interesujące rezultaty.

Korzyści dla branży gier wideo są liczne. Weźmy remastery, które są obecnie codziennością. Starsze tytuły obarczone są bagażem ograniczeń. Niektóre problemy łatwo pokonać, ale aktualizacja oprawy - zwłaszcza tekstur - wymaga ogromnych nakładów pracy. Nie powinno więc dziwić, że zastosowania SI zaczęły być wykorzystywane w tym celu już w 2020 roku, a później tylko zyskały na popularności. Wymienić można Chrono Cross: The Radical Dreamers Edition, Mass Effect Legendary Edition czy Grand Theft Auto: The Trilogy - The Definitive Edition. Efekty były różne. Skalowanie w górę działa dobrze, jeśli materiał źródłowy ma rozsądną jakość i nie za dużo detali. Obecne metody skalowania słabo radzą sobie za to z niską rozdzielczością, generując sporo artefaktów.

Ale co, jeśli chcemy wygenerować coś całkiem nowego, a nie tylko skalować? Tutaj do akcji wkraczają właśnie testowane aplikacje. Weźmy remaster Chrono Cross, który wygląda całkiem znośnie, ale na pewno nie idealnie - ze względu na niską rozdzielczość początkową. Jeśli jednak wrzucić źródło do Stable Diffusion i dodać odpowiednią podpowiedź, tworzymy całkiem nowy obraz, zachowujący wizualną kompozycję oryginału. Narysujemy tę samą jaskinię, z tymi samymi grzybami i kamieniami, ale w znacznie wyższej jakości. Modyfikując parametry, możemy stworzyć coś bardzo zbliżonego do oryginału - lub coś podobnego, zmieniającego na przykład ścieżkę w centrum. Przykłady w materiale wideo powyżej, zaczynając od okolic 4:35.

Dobrym celem są też tradycyjne tekstury w grach 3D. Resident Evil 4 działa dzisiaj na większości współczesnych platform, lecz tekstury rodem z szóstej generacji nie wyglądają najlepiej. Obecne gry stawiają na większą porcję detali, czego nie zapewni proste podniesienie rozdzielczości. Ponownie możemy jednak wykorzystać oryginał, by dodać nowe szczegóły z pomocą SI.

Ta sama technika może oczywiście posłużyć do przygotowania całkiem nowych tekstur dla gier. Zacząć można od ilustracji lub zdjęcia wraz z krótkim opisem, a Sztuczna Inteligencja zajmie się resztą. Możliwości są niemal nieskończone. Tworzenie tekstur i innych map tworzących materiały to obecnie istotna część procesu tworzenia oprawy graficznej, więc nowe technologie mogą zwolnić moce przerobowe.

Stable Diffusion ma spory potencjał w takich zastosowaniach, a Midjourney także - choć okrężną drogą - pozwala już dodać obraz „startowy”. Można wyobrazić sobie wygenerowanie setek pozycji, a następnie wybranie najlepszej. W DALL-E 2 jest trudniej, ponieważ musimy bazować na samym tekście. Co istotne, w Stable Diffusion możemy od razu generować obrazki z odpowiednio dostosowanymi krawędziami, co kluczowe w przypadku tekstur powtarzających się na płaskich powierzchniach.

Narzędzia mogą przydać się także na wcześniejszych etapach produkcji. Podczas procesu tworzenia gry potrzebne są niezliczone grafiki koncepcyjne, tworzące podwaliny pod wygląd całego projektu: broni, lokacji, postaci i tak dalej. Dzisiaj pracą zajmują się graficy rysujący na tabletach i w programach graficznych, co jest czasochłonne. Sztuczna Inteligencja działa tymczasem w sekundach. Kilka parametrów i mamy setki ilustracji. Te mogą służyć jako baza do dalszej pracy - lub gotowy koncept.

Wiele grafik koncepcyjnych tworzy się dzisiaj poprzez malowanie na trójwymiarowych obiektach. Wręczając SI podstawowy obrazek, możemy zrobić to samo. Wystarczy szkic, model 3D lub najprostszy nawet rysunek, a aplikacja przetworzy całość w wysokiej jakości obraz.

Łatwo o imponujące przykłady, lecz obecne modele SI na pewno nie są idealne. Trudno o jednolitą wizję artystyczną pomiędzy kolejnymi tworami, nawet przy korzystaniu z tych samych słów kluczowych. W bazach danych znajdują się ilustracja przygotowane przez multum technik i artystów. Wygenerowanie spójnych obrazów wymaga skrupulatnego konstruowania podpowiedzi, a później często także dokładnej selekcji rezultatów. Jak to często bywa, narzędzia są użyteczne, ale mają ograniczenia.

W przeszłości pracowałem w grafice cyfrowej, także w animacjach wykorzystujących sporą liczbę przygotowanych ilustracji. Generowanie ich z pomocą Sztucznej Inteligencji wydaje się idealnie pasować do tego typu pracy. Kto wie, może w przyszłości efekty będą tworzone w czasie rzeczywistym. Obecnie potrzeba sekund, nawet na szybkich kartach graficznych.

Nic nie stoi na przeszkodzie, by przenieść wygenerowane obrazu do programu graficznego i poprawić błędy i dodać lub usunąć elementy. Wystarczy kilka chwil, by pozbyć się większości artefaktów. Nie można też zapominać, że w przyszłości technologia tylko się rozwinie. Choć to co najmniej druga generacja aplikacji tego typu, to wydaje się, że rozwój nabiera obecnie tempa.

Już teraz wszystkie trzy produkty działają dobrze, więc która opcja jest najlepsza? Jeśli mowa o jakości, DALL-E 2 potrafi interpretować abstrakcyjne podpowiedzi i generuje kreatywne rezultaty. Można przygotować szczegółowy opis, ale ten program radzi sobie nawet z ogólnymi założeniami, bazującymi na szerokich pojęciach i tematach. Efekty są też zazwyczaj spójne. Dla przykładu, ludzie mają najczęściej odpowiednią liczbę kończyn i właściwe proporcje.

Stable Diffusion wymaga więcej pracy. Obecnie nie rozumie bardziej abstrakcyjnych pojęć. Jeśli jednak sprecyzujemy słowa kluczowe, efekty są bardzo dobre. Dużą przewagą jest możliwość wprowadzenie obrazu startowego - to potężny plus. Jeśli podkręcimy ustawienia, wygenerujemy rezultaty wysokiej jakości, prawdopodobnie najlepsze w tej generacji SI.

Midjourney sprawdza się w stylizacji - renderowaniu istniejącego konceptu w innym stylu, jak obraz lub szkic. Program nie gardzi też krótkimi podpowiedziami i oferuje wysokiej jakości rezultaty, choć jest być może nieco mniej „kreatywny”. Wykazuje także więcej artefaktów niż konkurencja; ma też problemy z właściwymi proporcjami. W naszej opinii to najgorsza opcja.

| DALL-E | Stable Diffusion | Midjourney | |

|---|---|---|---|

| Cena (USD) | 0,10 dol. za obraz | Za darmo (na własnym PC) | Darmowy limit lub 30 dol. za miesiąc przy braku limitów |

| Dostęp | Zaproszenie | Otwarty | Otwarty |

| Działanie | Strona internetowa | Strona internetowa/lokalnie | Strona internetowa |

| Kod | Zamknięty | Otwarty | Zamknięty |

DALL-E 2 oraz Midjourney dostępne są komercyjnie, z poziomu przeglądarki. Interfejsy są proste w użyciu. W tym pierwszym przypadku potrzebne jest zaproszenie, choć można zapisać się na listę oczekujących. Stable Diffusion jest natomiast darmowe i wydane w open-source. Plusem jest konieczność uruchamiania programu na własnym komputerze, a - co za tym idzie - lepsza integracja podczas pracy.

Nie może zabraknąć analizy wydajności. DALL-E 2 jest szybsze niż Midjourney, lecz oba działają przez sieć, więc posiadana konfiguracja sprzętu nie ma znaczenia. DALL-E 2 potrzebuje około 10 sekund na wygenerowanie podstawowego obrazu, a Midjourney - ok. 1 minuty. Prędkość działania Stable Diffusion będzie oczywiście zależała od komputera i wybranej jakości.

Laptop z RTX 3080 potrzebuje 3-4 sekund na ilustrację 512 × 512. Zwiększanie rozdzielczości wydłuża czas do 30-40 sekund, podobnie jak skomplikowany materiał bazowy. Jak na oprogramowanie open-source przystało, pobrać można wiele różnych aplikacji, o różnym poziomie komplikacji interfejsu. Wydajność powinna być jednak podobna.

Stable Diffusion do poprawnego działania potrzebuje karty graficznej co najmniej z rodziny RTX 1000, a także tyle pamięci VRAM, ile jesteśmy w stanie zapewnić. Na laptopie z RTX 3080 jesteśmy ograniczeni do zaledwie 640 × 640, choć całość można później skalować wyżej za pomocą innych narzędzi. Włączenie aplikacji na GPU od AMD czy na komputerach Mac wymaga nieco dodatkowego kombinowania.

Bazując na naszych doświadczeniach, generowanie obrazów przez SI to wspaniała, przełomowa technologia. Wpisuje słowa, dostajemy obrazki. Brzmi jak science-fiction - z tą różnicą, że działa już teraz. Co więcej, to dopiero początek. Zastosowań jest całe mnóstwo, a wydaje się przecież, że widzimy zaledwie wierzchołek góry lodowej. Zwłaszcza świat gier wideo wydaje się pasować idealnie.

Największym ograniczeniem jest obecnie cena. DALL-E 2 jest stosunkowo drogie, a Stable Diffusion wymaga mocnej karty graficznej do lokalnego działania. Uzyskanie obrazu wysokiej jakości wymaga często odrzucenia wielu słabszych propozycji, co może szybko podnieść koszty - nie tylko w pieniądzach, ale i w czasie.

Jaka przyszłość czeka te narzędzia? Przez ostatnie lata o Sztucznej Inteligencji sporo się mówiło, ale praktyczne zastosowania były raczej interesującymi ciekawostkami, a nie czymś namacalnym. Ostatnie kilka miesięcy to jednak prawdziwa rewolucja, z kilkoma premierami narzędzi do generowania obrazów wysokiej jakości. Przyszłość pokaże, czy rozwój będzie trwał, czy też pojawią się niespodziewane ograniczenia. Z całą pewnością wiadomo, że powstaje potężne, nowe narzędzie do tworzenia.