Digital Foundry kontra Watch Dogs

Jeszcze jeden włam - porównanie wersji PC, PS4 i Xbox One.

Watch Dogs, uruchomione na Xbox One tuż po sesji na PlayStation 4, dostarcza zaskakująco przyjemnych wrażeń. 792p? Naprawdę? Oparte na silniku gry scenki fabularne - podobnie jak wiele innych sekwencji - trzymają bardzo zbliżony poziom, i to nie tylko w zestawieniu z wersją na PS4, ale również pecetową, wyświetlaną w 1080p. Różnice pogłębią się, gdy rozpoczniemy rozgrywkę, ale już na wstępie bez trudu zauważymy, że w Watch Dogs najważniejsze jest oświetlenie, efekty i sposób, w jaki współgrają z różnymi materiałami - a na tym polu gra prezentuje się bardzo korzystnie, nawet pomimo różnicy w rozdzielczości. Titanfall, również wyświetlany w 792p, wypadł dość blado na tle swojego odpowiednika w wysokiej rozdzielczości, ale Watch Dogs na Xbox One wychodzi z porównania obronną ręką.

Jeśli mielibyśmy jednym słowem podsumować różnice dzielące wersje Watch Dogs na PS4 i XOne, byłoby to „udoskonalenie”. Mniej rzucający się w oczy aliasing, rzadszy tearing - to nadal ta sama gra, ale na platformie Sony jakby odrobinę bardziej dopracowana, solidniejsza. W takich okolicznościach oczywiście zdecydujemy się na wybór bardziej doszlifowanej wersji, ale właściciele Xbox One powinni mieć świadomość, że na płaszczyźnie rozgrywki Ubisoft Montreal dostarczył na ich konsolę grę identyczną, jak u konkurencji.

Na pececie sprawy mają się już zgoła inaczej. Choć AMD i Nvidia wydały sterowniki opracowane - jak twierdzą - z myślą o Watch Dogs, to rozgrywce na najwyższych ustawieniach towarzyszą odpychające problemy techniczne. W trakcie testów wypróbowaliśmy GTX 780 SLI, Radeona R9 290X, GTX 780 Ti, a nawet GTX Titan wyposażonego 6GB pamięci, a każdą z kart wsparliśmy sześciordzeniowym procesorem Intel i7 3930K - CPU o mocy daleko wykraczającej poza rekomendowaną konfigurację. Za każdym razem borykaliśmy się z problemami płynności i spójności jednolitości animacji, których rozwiązanie wymagałoby przemodelowania sposobu, w jaki sprzęt AMD współpracuje z grą.

Zacznijmy od porównania grafiki. Wykorzystamy do tego materiały z PS4 i Xbox One - zgrane w 1080p - oraz z peceta na ustawieniach ultra, z blokadą animacji na poziomie 30 klatek na sekundę, by uniknąć problemów z wydajnością. Idealne zgranie trzech wersji gry nie należy do najłatwiejszych zadań, głównie dlatego, że pora dnia i warunki pogodowe ulegają nieustannej zmianie - stąd właśnie różnice w oświetleniu, które można wyłapać w naszym materiale.

- Poza nagraniami przygotowaliśmy również obszerną galerię screenów, na których porównaliśmy ze sobą poszczególne wersje Watch Dogs.

„Rozdzielczość 792p nie sprawdziła się najlepiej w przypadku Titanfall - znacznie lepiej pasuje do filmowej stylistyki Watch Dogs.”

Prawdę powiedziawszy, od czasu opublikowania analizy wydajności Watch Dogs, nasza opinia dotycząca jakości obrazu nie uległa znaczącej zmianie. Kwestia różnicy rozdzielczości między Xbox One, PS4 i pecetem na dopasowanych przez nas ustawieniach (w tym przypadku w natywnym 1080p) zamazuje się podczas scenek przerywnikowych, dając o sobie znać dopiero w trakcie rozgrywki - uwydatniają ją zwłaszcza obiekty podświetlone ikonami hakowania. Odnieśliśmy wrażenie, że niektóre elementy HUD-a na konsolach potraktowano antyaliasingiem w post-processingu, przez co na Xbox One prezentują się odrobinę gorzej, ale nie jest to problem, który przekreślałby zalety tej wersji gry.

Na konsolach wykorzystano też inne cienie - krawędzie na PS4 są bardziej postrzępione względem wersji pecetowej, a na Xbox One mają niższą rozdzielczość - ale różnice dają o sobie znać dopiero z bliska, zwłaszcza podczas scenek przerywnikowych. W trakcie rozgrywki łatwo wychwycić, że w każdej z edycji zaimplementowano inną jakość cieni, ale żadna nie wyróżnia się jednoznacznie na minus. Różnice najłatwiej wychwycić, gdy zestawimy wersje konsolowe z pecetową, gdzie na ustawieniach „utlra” cienie nabierają zupełnie nowej jakości.

Kolejnej różnicy dostarcza użycie efektu ambient occlusion, który daje o sobie znać zwłaszcza podczas wydarzeń rozgrywających się w środku dnia, dodając głębi scenie. MHBAO to wersja Ambient Occlusion wewnętrznie opracowana przez Ubisoft, o której Nvidia mówi, że jest wyświetlana w „o połowę niższej rozdzielczości, w jakości konsolowej” - i najwyraźniej właśnie to rozwiązanie wykorzystano w wersjach gry na PS4 i Xbox One oraz jako wyjściowe ustawienie pecetowe. Na konsoli Microsoftu efekt jest dużo mniej sugestywny, z kolei pecetowcy mogą napawać oczy opracowaną przez Nvidię HBAO+, które odpalimy na dowolnej karcie graficznej. Na wysokich ustawieniach jakość efektu dostarcza rewelacyjnych wrażeń - dlatego doradzamy, by gracze zdecydowali się właśnie na nią. Efekt obciąża nieco GPU, ale sprawiedliwie traktuje wszystkie karty, również te niepochodzące ze stajni Nvidii.

Na innych płaszczyznach zauważyliśmy zrównanie wersji na Xbox One i PS4 - to ciekawe odkrycie, biorąc pod uwagę istnienie dokumentu XML, w którym opisano ustawienia jakości otoczenia, roślinności i budynków dla Xbox One.

Choć staraliśmy się ze wszystkich sił, nie udało nam się dostrzec różnic między poszczególnymi platformami. Być może deweloperzy opracowali wspomniany kod z myślą o niestandardowym modelu Xboksa lub też ustawienia to pozostałości wymazanego już kodu. Bez względu na to jak brzmiałaby odpowiedź, gracze nie powinni się martwić. Inne elementy graficzne - choćby wymagająca pod względem obliczeń symulacja wody - wyglądają identycznie na obu platformach. Duży skok jakościowy zauważymy dopiero na pececie na ustawieniach ultra.

Dyrektor kreatywny Watch Dogs, Jonathan Morin stwierdził, że konsolowe wersje gry odpowiadają wysokim ustawieniom na pececie i nie da się ukryć, że oferują one większość tego, co gra ma do pokazania. Jednakże, poza znacznie usprawnioną symulacją wody, na „ultra” zobaczymy też poprawione dynamiczne refleksy świetlne i rozciągający się dalej horyzont (choć ten akurat efekt trudno wyłapać w środowisku miejskim). Ustawienia ultra to luksus, na który pozwolą sobie tylko właściciele najlepszych GPU, ale oferowane usprawnienia są miłym dodatkiem.

Poza różnymi poziomami jakości renderingu dostępne są również ustawienia dla antyaliasingu: FXAA, SMAA, konsolowe temporal SMAA, MSAA oraz TXAA. Przygotowując porównanie, zdecydowaliśmy się na SMAA - oferujące najlepszy kompromis jakości i wydajności, ale musimy też wspomnieć o obecności TXAA od Nvidii. Wielu graczom ta wariacja antyaliasingu nie odpowiada ze względu na nadmierne rozmycie szczegółów. Prawda jest jednak taka, że TXAA idealnie pasuje do filmowej stylistyki Watch Dogs. Już wersja 2x wygląda dobrze, ale 4x jest od niej lepsza - tyle że bardziej obciąża GPU.

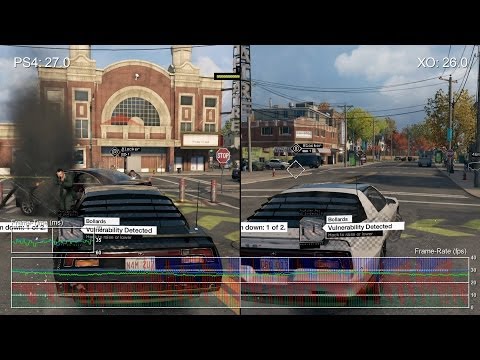

We wcześniejszym artykule zdążyliśmy już poruszyć temat wydajności wersji konsolowych - i na ten temat mamy niewiele do dodania. Na PS4 Watch Dogs jest wyświetlany w 30 klatkach, a gdy silnik nie radzi sobie z wyrenderowaniem kolejnej klatki w odstępie 33 ms, sytuację ratuje v-sync. Ogólnie rzecz biorąc, płynność nie spada poniżej wyznaczonego progu - wyjątek stanowią sceny z dużą ilością pojazdów i eksplozji. Xbox One radzi sobie podobnie - choć tearing jest nieco częstszy i bardziej zauważalny. W przeciwieństwie do wersji na PS4, screen tear może zaatakować także w scenkach przerywnikowych oraz gdy siadamy za kierownicą.

Odnosimy wrażenie, że Ubisoft skoncentrował swoje wysiłki na optymalizacji wersji na PS4, po czym silnik został zeskalowany pod Xbox One, gdzie utrzymanie stałych 30 klatek nie było już tak palącym priorytetem. W efekcie otrzymaliśmy bardzo solidny tytuł na PS4 i nieco bardziej rozchybotany - choć nadal w pełni działający - na konsoli Microsoftu.

„Wydajność gry na obu konsolach jest bardzo zbliżona, ale PS4 lepiej radzi sobie z zachowaniem płynności.”

Z kolei wersja pecetowa nadal wymaga oszlifowania. Nie możemy zrozumieć, dlaczego porządna karta z wyższej półki - jak GTX 780 czy R9 290 - nie radzi sobie z wyświetlaniem gry w 60 klatkach w 1080p na najwyższych ustawieniach, a GTX 770 i 280X na wysokich. Na sprzęcie wysokiej klasy zauważyliśmy wyraźne spadki wydajności, a co więcej, w Watch Dogs zarysowała się ogromna różnica osiągów dwóch odpowiadających sobie kart od różnych producentów (różnica jest do tego stopnia zauważalna, że AMD zasugerowało, jakoby integracja przez Nvidię GameWorks utrudniała zoptymalizanie gry pod Radeony), czemu konkurent AMD stanowczo zaprzecza. Mając w pamięci, że owa integracja sprowadza się do dwóch trybów antyaliasingu i dodania efektu ambient occlusion, jesteśmy skłonni uwierzyć Nvidii na słowo.

Ale dość już tej polityki - ważne jest to, że gracze, którym zależy na 60 klatkach na sekundę, mają przed sobą nieliche wyzwanie. Głównym winowajcą jest chyba sposób zarządzania teksturami - po prostu strumieniowanie zasobów o jakości „ultra” do i z RAM-u nie odbywa się wystarczająco szybko, co owocuje zauważalnym stutterem (swoistą ekranową „czkawką”). Z naszych testów wynika, że nie jest to wina RAM-u - gdy GTX 780 Ti z 3GB zastąpiliśmy GTX Titanem z 6GB, efekt był identyczny. Udało nam się poprawić wydajność, obniżając jakość tekstur z „ultra” na „wysokie”, ale nawet wtedy nie pozbyliśmy się do końca nieprzyjemnych zakłóceń wyświetlania. Nie jest to również wina ustawień - na potrzeby testu zeszliśmy do „średnich”, a i tak zdarzały nam się spadki wydajności. Grę odpalaliśmy z SSD podłączonego przez SATA3.

Po przeskoczeniu na odpowiednik tej karty po stronie AMD - Radeona R9 290X wyposażonego w 4 GB - efekty były zdumiewające. Przy włączonym v-syncu i ustawieniach ultra dla tekstur z rzadka tylko udało nam się przekroczyć próg 30 klatek. Dopiero po zejściu do „średnich” ustawień udało nam się na dobre przełamać granicę 33 ms dla renderingu kolejnych klatek, ale nawet wtedy stuttering sprawił, że efekt okazał się niewart wysiłku włożonego w dopasowanie ustawień. Oczywiście po wyłączeniu v-synca liczba klatek podskoczyła, ale nawet wtedy benchmarki wykazały, że gra najzwyczajniej w świecie nie jest zoptymalizowana pod sprzęt AMD.

„Na pececie nie lada problemów nastręczyło nam osiągnięcie jednolitej płynności animacji - stutter jest nie do opanowania.”

Twórcy muszą jeszcze dopracować strumieniowanie tekstur do RAM-u, a niska wydajność Radeonów kłóci się z faktem, że przecież w PS4 wykorzystano podobną architekturę. Wiemy, że Ubisoft pracuje nad rozwiązaniem tych problemów, ale jak na dłoni widać, że czeka ich długa droga. Na razie najbardziej zadowoleni będą właściciele kart Nvidii - obniżenie jakości tekstur do „wysokich” nie odbija się na jakości oprawy wizualnej, a stuttering pojawia się tylko, gdy pędzimy samochodem przez miasto. W trakcie spokojniejszej rozgrywki problem nie jest już tak wyraźny, a podczas misji niemalże zanika.

Posłużyliśmy się przykładem konfiguracji z wyższej półki, chcąc podkreślić, jak głęboko zakorzenione są problemy z grą i że nie rozwiąże ich inwestycja w lepszy sprzęt. Warto jednak zauważyć, że na GTX 780 od Nvidii gra - na najwyższych ustawieniach i z włączonym v-synciem - zbliża się do 1080p60. Przetestowaliśmy także GTX 760, jednak okazało się, że animacji oscyluje między 30-40 klatkami i ostatecznie doszliśmy do wniosku, że wolimy postawić na lepszą oprawę graficzną w 30 klatkach, niż uganiać się za 60 fps-ami. Karta umożliwia wyświetlanie gry na poziomie ultra z temporal SMAA w 1080p. Po przejściu na GTX 750 Ti uzyskaliśmy podobne rezultaty na „wysokich” ustawieniach - czyli, ogólnie rzecz biorąc, jakość oprawy odpowiadała tej z PS4, tyle że w pełnym 1080p. Przypomniała nam się sytuacja z Assassin's Creed IV, gdy przy włączonym v-syncu zasoby GPU były przekierowywane na poprawienie oprawy, ale płynności już niekoniecznie.

Skoro o wersji pecetowej mowa, to warto wspomnieć o imponującej technologii, którą Ubisoft Montreal określa mianem v-syncu dwuklatkowego. Jeśli twój monitor wyświetla obraz w 60 Hz, v-sync zablokuje animację na 30 klatkach, dbając o wyświetlanie ich w odpowiednich przedziałach czasu. W ten sposób obniżamy wydajność, ale nie bez powodu większość deweloperów tworzących na konsole stosuje blokadę płynności na poziomie 30 klatek: rozgrywka nabiera jednolitości, a CPU może odetchnąć; wykonanie symulacji w 33 ms jest znacznie łatwiejsze, niż w 16 ms, wymaganych przy 60 klatkach na sekundę.

Watch Dogs: werdykt Digital Foundry

Pecetowe Watch Dogs powinno okazać się najlepszą wersją, ale stąpa po grząskim gruncie licznych problemów. Dyrektor techniczny gry Sebastien Viard zwrócił nam uwagę, że większości z nich winien jest brak zunifikowanego RAM-u, potwierdzając przy okazji, że Ubisoft pracuje nad ich rozwiązaniem. Jednak w momencie pisania artykułu, osiągnięcie progu stałych 1080p60 może okazać się bardzo trudne nawet na najmocniejszych konfiguracjach sprzętu.

Mając w pamięci, jak pazerna jest gra na zasoby CPU (co prawda rozpoznaje, że procesor ma osiem rdzeni, ale korzysta tylko z sześciu, mocno je obciążając), a także problemy z GPU, chyba najlepszym wyjściem dla graczy będzie zablokowanie animacji na 30 klatkach w 1080p i wybór wyższych ustawień graficznych. Na razie lepiej trzymać się z dala od tekstur na „ultra”.

Co się tyczy konsol, to bez chwili zastanowienia rekomendujemy wersję na PS4: wydajność gry jest lepsza niż na Xbox One, nie wspominając o wyższej rozdzielczości. Musimy jednak podkreślić, że przez większość czasu rozgrywki gra zachowuje się identycznie, a w akcji 792p wcale nie jest takie straszne, jak mogłyby sugerować suche liczby.

Dzięki filmowemu wykorzystaniu efektów wizualnych oraz charakterystycznej estetyce, stroniącej od nierównych krawędzi i drobnych szczególików, gra pod względem oprawy prezentuje się bardzo podobnie bez względu na to, czy gramy w 792p, 900p czy 1080p. Obie wersje konsolowe są godne polecenia, choć jeśli gracz ma taką możliwość, rekomendujemy edycję na PS4 - gra zyskała w niej dodatkowe szlify, a cena jest identyczna.